5) СПОСОБ КОРРЕЛЯЦИОННЫХ ПЛЕЯД

Терентьевым был изобретен способ корреляционных плеяд. Сущность способа такова. Визуально результаты классификации возможно представить в виде цилиндра, рассеченного плоскостями, перпендикулярными его оси. Плоскости соответствуют его уровням (от 0 до 1 с шагом 0,1), на которых объединяются параметры либо объекты, подлежащие классификации, исходя из этого способ напоминает способ ближней связи, но с фиксированными уровнями объединения. Графически результаты классификации изображают в виде окружностей – срезов (плеяд) вышеупомянутого корреляционного цилиндра. На окружностях отмечают классифицируемые объекты. Связи между классифицированными объектами показывают методом соединения хордами точек окружности, соответствующих объектам.

6) ВРОЦЛАВСКАЯ ТАКСОНОМИЯ

Результатом работы программы, применяющей способ большого корреляционного пути, являются пары чисел, показывающие порядок «соединения» подлежащих классификации параметров либо объектов, самый родных попарно. Получающийся малейший замкнутый путь возможно отобразить графически в виде оптимального дерева (дендрита), как это обрисовано в следующем разделе.

Классифицируемы смогут быть параметры или объекты. Способ похож на способ ближайшей связи, но относится к методам типа разрезания графа и напоминает способы вроцлавской таксономии. В случае, если в качестве меры сходства используется коэффициент корреляции, получается способ большого корреляционного пути.

Способы иерархической группировки (численной таксономии) исходных множеств стали называться кластер-анализа, другими словами анализа групп. Первоначально они использовались в палеонтологии и биологии, а на данный момент активно применяются в разных отраслях геолого-минералогических наук, например, при классификации парагенетических ассоциаций элементов земной коры.

Термин кластерный анализ (в первый раз ввел Tryon, 1939) в конечном итоге включает в себя комплект разных методов классификации. Неспециализированный вопрос, задаваемый исследователями во многих областях, пребывает в том, как организовать замечаемые данные в наглядные структуры, другими словами развернуть таксономии. К примеру, биологи ставят цель разбить животных на разные виды, дабы содержательно обрисовать различия между ними. В соответствии с современной совокупностью, принятой в биологии, человек принадлежит к приматам, млекопитающим, амниотам, позвоночным и животным. Увидьте, что в данной классификации, чем выше уровень агрегации, тем меньше сходства между участниками в соответствующем классе. Человек имеет больше сходства с другими приматами (другими словами с мартышками), чем с «отдаленными» участниками семейства млекопитающих (к примеру, псами) и т.д. Практически, кластерный анализ есть не столько простым статистическим способом, сколько «комплектом» разных методов «распределения объектов по кластерам». Существует точка зрения, что в отличие от многих вторых статистических процедур, способы кластерного анализа употребляются как правило тогда, в то время, когда вы не имеете каких-либо априорных догадок довольно классов, но все еще находитесь в описательной стадии изучения. направляться осознавать, что кластерный анализ определяет «самый допустимо значимое ответ». Исходя из этого проверка статистической значимости в конечном итоге тут неприменима, кроме того в случаях, в то время, когда известны p-уровни (как, к примеру, в способе K-средних).

Задача кластер-анализа сводится к разбиению множества элементов корреляционной матрицы показателей [R] на группы так, дабы в них объединялись объекты с наивысшими значениями черт сходства, а разобщенные группы оставались бы наряду с этим максимально изолированными по этому показателю. В качестве меры сходства смогут употребляться конкретно парные коэффициенты корреляции, m-мерное эвклидово расстояние либо другие дистанционные коэффициенты.

МЕТРИКИ

Мера сходства между элементами множеств (типа расстояния) именуется метрикой, если она удовлетворяет определенным условиям: симметрии, неравенству треугольника, различимости нетождественных объектов и неразличимости тождественных объектов.

Метрика Минковского

самая общей метрикой есть метрика Минковского. Степень разности значений возможно выбрать в пределах от 1 до 4. В случае, если эту степень забрать равной 2, то возьмём евклидово расстояние. Расстояние Минковского равняется корню r-ой степени из суммы безотносительных разностей пар значений забранных в r-ой степени:

distance(x,y) = {Si (xi — yi)r }1/r

Евклидова метрика

Это чаще всего выбираемый тип расстояния. Это легко геометрическое расстояние в многомерном пространстве. Евклидова расстояние между двумя точками х и у – это мельчайшее расстояние между ними. В двух- либо трёхмерном случае – это прямая, соединяющая эти точки. В случае, если в метрике Минковского положить r=2, мы возьмём стандартное евклидово расстояние (евклидову метрику)

distance(x,y) = {Si (xi — yi)2 }½

Квадратная евклидова метрика (квадрат евклидова расстояния)

Дает больший если сравнивать с евклидовой метрикой вес объектов, каковые размещаются более обособленно. Благодаря возведению в квадрат при расчёте лучше учитываются громадные разности

distance(x,y) = Si (xi — yi)2

Манхеттенское расстояние

Это расстояние легко среднее различие поперечных измерений. При r=1 метрика Минковского дает манхеттенское расстояние (метрику города, city block, Manhattan distance). Эта дистанционная мера, именуемая кроме этого расстоянием Манхэттена либо не в серьез – расстоянием таксиста, определяется суммой полных разностей пар значений. Для двумерного пространства это не прямолинейное евклидова расстояние между двумя точками, а путь, что обязан преодолеть Манхэттенский таксист, дабы проехать от одного дома к второму по улицам, пересекающимся под прямым углом

distance(x,y) = Si |xi — yi|

Чебышевское расстояние

Эта мера расстояния возможно соответствующая в случаях, в то время, когда любой желает выяснить два объекта как «разные», если они разны на любом из измерений. Разностью двух наблюдений есть безотносительное значение большой разности последовательных пар переменных, соответствующих этим наблюдениям.

distance(x,y) = Maximum|xi — yi|

Пользовательская метрика (степенное расстояние)

Это обобщенный вариант расстояния Минковского. Это расстояние, именуемое кроме этого степенным расстоянием, равняется корню r-ой степени из суммы безотносительных разностей пар значений забранной в р-ой степени:

distance(x,y) = (Si |xi — yi|p)1/r,

где r и p — определяемые пользователем параметры. Тут как для корня, так и для степени суммы возможно выбирать значения от 1 до 4. Параметр p важен за постепенное взвешивание разностей по отдельным координатам, параметр r важен за прогрессивное взвешивание громадных расстояний между объектами. В случае, если r и p равны 2, то это расстояние равняется евклидовому расстоянию.

Процент различия (несогласия)

Эта мера употребляется в тех случаях, в то время, когда эти являются категориальными. Это расстояние вычисляется как:

distance(x,y) = (Number of xi ¹ yi)/i

ПРАВИЛА ОБЪЕДИНЕНИЯ Либо СВЯЗИ

На первом шаге, в то время, когда любой объект представляет собой отдельный кластер, расстояния между этими объектами определяются выбранной мерой. Но в то время, когда связываются совместно пара объектов, появляется вопрос, как направляться выяснить расстояния между кластерами? Иначе говоря нужно правило объединения либо связи для двух кластеров. Тут имеются разные возможности: к примеру, вы имеете возможность связать два кластера совместно, в то время, когда каждые два объекта в двух кластерах ближе друг к другу, чем соответствующее расстояние связи. Иначе говоря вы используете «правило ближайшего соседа» для определения расстояния между кластерами; данный способ именуется способом одиночной связи. Это правило сооружает «волокнистые» кластеры, другими словами кластеры, «сцепленные совместно» лишь отдельными элементами, случайно появлявшимися ближе остальных друг к другу. Как альтернативу вы имеете возможность применять соседей в кластерах, каковые находятся дальше всех остальных пар объектов друг от друга. Данный способ именуется способ полной связи. Существует кроме этого множество вторых способов объединения кластеров, аналогичных тем, что были рассмотрены.

Одиночная сообщение (способ ближайшего соседа).Как было обрисовано выше, в этом способе расстояние между двумя кластерами определяется расстоянием между двумя самый родными объектами (ближайшими соседями) в разных кластерах. Это правило должно, в известном смысле, нанизывать объекты совместно для создания кластеров, и результирующие кластеры имеют тенденцию быть представленными долгими «цепочками».

Полная сообщение (способ самый удаленных соседей).В этом способе расстояния между кластерами определяются громаднейшим расстоянием между любыми двумя объектами в разных кластерах (другими словами «самый удаленными соседями»). Данный способ в большинстве случаев трудится отлично, в то время, когда объекты происходят в действительности из реально разных «рощ». В случае, если же кластеры имеют в некоем роде удлиненную форму либо их естественный тип есть «цепочечным», то данный способ негоден.

Невзвешенное попарное среднее.В этом способе расстояние между двумя разными кластерами вычисляется как среднее расстояние между всеми парами объектов в них. Способ действен, в то время, когда объекты в конечном итоге формируют разные «рощи», но он трудится одинаково отлично и в случаях протяженных («цепочного» типа) кластеров. Напомним, что в собственной книге Снит и Сокэл (Sneath, Sokal, 1973) вводят сокращение UPGMA для ссылки на данный способ, как на способ невзвешенного попарного арифметического среднего — unweighted pair-group method using arithmetic averages.

Взвешенное попарное среднее.Способ аналогичен способу невзвешенного попарного среднего, за исключением того, что при вычислениях размер соответствующих кластеров (другими словами число объектов, содержащихся в них) употребляется в качестве весового коэффициента. Исходя из этого предлагаемый способ должен быть использован (скорее кроме того, чем прошлый), в то время, когда предполагаются неравные размеры кластеров. В книге Снита и Сокэла (Sneath, Sokal, 1973) вводится сокращение WPGMA для ссылки на данный способ, как на способ взвешенного попарного арифметического среднего — weighted pair-group method using arithmetic averages.

Невзвешенный центроидный способ.В этом способе расстояние между двумя кластерами определяется как расстояние между их центрами тяжести. Снит и Сокэл (Sneath and Sokal (1973)) применяют сокращение UPGMC для ссылки на данный способ, как на способ невзвешенного попарного центроидного сглаживания — unweighted pair-group method using the centroid average.

Взвешенный центроидный способ (медиана). Данный способ аналогичен прошлому, за исключением того, что при вычислениях употребляются веса для учёта отличия между размерами кластеров (другими словами числами объектов в них). Исходя из этого, в случае, если имеются (либо подозреваются) большие отличия в размерах кластеров, данный способ оказывается предпочтительнее прошлого. Снит и Сокэл (Sneath, Sokal 1973) применяли сокращение WPGMC для ссылок на него, как на способ невзвешенного попарного центроидного сглаживания — weighted pair-group method using the centroid average.

Способ Варда.Данный способ отличается от всех других способов, потому, что он применяет способы дисперсионного анализа для оценки расстояний между кластерами. Способ минимизирует сумму квадратов (SS) для любых двух (гипотетических) кластеров, каковые смогут быть организованы на каждом шаге. Подробности возможно отыскать в работе Варда (Ward, 1963). В целом способ представляется весьма действенным, но он пытается создавать кластеры малого размера.

ВИЗУАЛИЗАЦИЯ РЕЗУЛЬТАТОВ КЛАСТЕРНОГО АНАЛИЗА

По окончании проведения классификации рекомендуется визуализировать результаты кластеризации методом построения дендрограммы (дендограммы). Для солидного числа объектов такая визуализация есть единственным методом взять представление об неспециализированной конфигурации объектов.

Не смотря на то, что от графического представления данных во многих способах возможно отказаться, иерархические способы кластерного анализа становятся более наглядными, в случае, если результаты расчета представить в виде особого графика, именуемого дендрограммой (дендограммой).

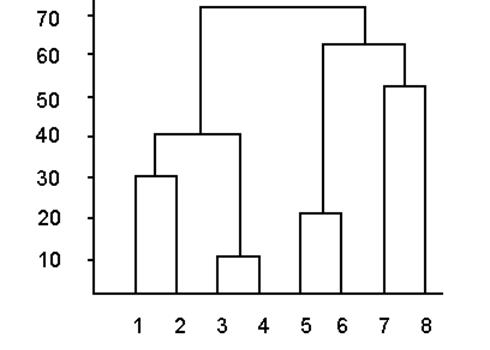

Предположим, по окончании применения одного из иерархических способов взяты результаты классификации в виде размеров связи для пар объектов. Мысль построения дендрограммы очевидна – пары объектов соединяются в соответствии с уровнем связи, отложенным по оси ординат (рис. VII.1).

Рис. VII.1. Дендрограмма иерархического способа

Диаграмма начинается с каждого объекта в классе (в нижней части диаграммы). Сейчас представим себе, что понемногу (малыми шагами) вы «ослабляете» ваш критерий о том, какие конкретно объекты являются неповторимыми, а какие конкретно нет. Иначе говоря вы понижаете порог, относящийся к ответу об объединении двух либо более объектов в один кластер. В следствии, вы связываете совместно всё большее и большее число объектов и агрегируете (объединяете) все больше кластеров, складывающихся из все посильнее различающихся элементов. Совсем, на последнем шаге все объекты объединяются совместно. На этих диаграммах вертикальные оси воображают расстояние объединения (в горизонтальных древовидных диаграммах горизонтальные оси воображают расстояние объединения). Так, для каждого узла в графе (в том месте, где формируется новый кластер) вы имеете возможность видеть величину расстояния, для которого соответствующие элементы связываются в новый единственный кластер. В то время, когда эти имеют ясную «структуру» в терминах кластеров объектов, сходных между собой, тогда эта структура, вероятнее, должна быть отражена в иерархическом дереве разными ветвями. В следствии успешного анализа способом объединения появляется возможность найти кластеры (ветви) и трактовать их.

По оси абсцисс находятся символические обозначения объектов изучения (векторов матрицы), а по оси ординат – минимальные значения дистанционных коэффициентов, соответствующих каждому шагу классифицирующей процедуры. Так, ось ординат употребляется для масштабного представления иерархических уровней группирования.

содержательная ценность и Наглядность древовидных графов значительно повышаются, в случае, если в них отражена информация не только о тесноте внутригрупповых связей, но и о межгрупповых расстояниях h. Таковой дендровидный граф, учитывающий не только внутригрупповые расстояния, но и средние расстояния между группами, именуется дендрографом.

Рудные тела редкометалльного месторождения приурочены к территориям натровых метасоматитов (альбититов). В следствии детального изучения минерального состава метасоматитов было обнаружено, что на месторождении развиты альбититы двух типов. Причем редкометалльное оруденение характерно только для одного из них. По составу рудные и безрудные альбититы очень близки, исходя из этого различить их по содержанию отдельных химических элементов не удается. Но кое-какие различия в минеральном составе проявляются в изюминках корреляционных связей между элементами. Наглядно эти различия отражаются на графах (рис. VII.2, а, б) и дендрограммах (рис. VII.2, в, г). В качестве меры близости элементов при построении дендрограмм в этом случае употребляются конкретно парные коэффициенты корреляции, вычисленные по 50 пробам, отобранным из рудных и безрудных альбититов, тип которых конкретно выяснен минералогическими изучениями. Предельное значение коэффициента корреляции для доверительной возможности 0,95 при количестве выборок в 50 проб равен 0,28. Исходя из этого для целей классификации целесообразно сравнивать только те группы, для которых коэффициенты корреляции, отражающие тесноту внутригрупповой связи, превышают эту величину.

Для обеих дендрограмм характерна несколько, объединяющая редкоземельные элементы и фосфор, что, по-видимому, обусловлено присутствием в альбититах обоих типов апатита, в составе которого отмечены повышенные концентрации этих элементов.

Главной отличительной изюминкой безрудных альбититов есть тесная ассоциация сидерофильных элементов (Ni—Cr—Ti—Со), которая в рудных альбититах распадается.

Для рудных альбититов характерна ассоциация халькофильных элементов (Pb—Zn), тогда как в безрудных альбититах корреляционная связь между этими элементами отрицательная. Так кластер-анализ разрешает оперативно и достаточно надежно выяснить тип альбититов по итогам спектральных анализов, не прибегая к детальному изучению шлифов.

Рис VII.2. Характеристики корреляционных связей между содержаниями химических элементов в альбититах:

а—граф по безрудным альбититам; б—граф по рудным альбититам; в—дендрограмма по безрудным альбититам; г—дендрограмма по рудным альбититам

СПОСОБ K-СРЕДНИХ

Данный способ кластеризации значительно отличается от таких агломеративных способов, как древовидная кластеризация. Предположим, вы уже имеете догадки относительно числа кластеров (по наблюдениям либо по переменным). Вы имеете возможность указать совокупности образовать ровно три кластера так, дабы они были так разны, как это допустимо. Это конкретно тот тип задач, каковые решает метод способа K-средних. В общем случае способ K-средних сооружает ровно K разных кластеров, расположенных на допустимо громадных расстояниях друг от друга.

С вычислительной точки зрения вы имеете возможность разглядывать данный способ, как дисперсионный анализ «напротив». Программа начинает с K случайно выбранных кластеров, а после этого изменяет принадлежность объектов к ним, дабы: (1) — минимизировать изменчивость в кластеров, и (2) — максимизировать изменчивость между кластерами. Этот метод подобен способу «дисперсионный анализ напротив» в том смысле, что критерий значимости в дисперсионном анализе сравнивает межгрупповую изменчивость с внутригрупповой при проверке догадки о том, что средние в группах отличаются друг от друга. В кластеризации способом K-средних программа перемещает объекты (другими словами наблюдения) из одних групп (кластеров) в другие для того, чтобы получить важнейший итог при проведении дисперсионного анализа

В большинстве случаев, в то время, когда результаты кластерного анализа способом K-средних взяты, возможно вычислить средние для каждого кластера по каждому измерению, дабы оценить, как кластеры различаются друг от друга. В совершенстве вы должны взять очень сильно различающиеся средние для большинства, если не для всех измерений, применяемых в анализе. Значения F-статистики, полученные для каждого измерения, являются вторым индикатором того, как отлично соответствующее измерение дискриминирует кластеры.

ФАКТОРНЫЙ АНАЛИЗ

Главным объектом изучения способами факторного анализа есть корреляционная матрица, выстроенная с применением коэффициента корреляционного отношения Пирсона (для количественных показателей). Предлагается кроме этого применение вторых коэффициентов типа корреляции, предназначенных для порядковых, качественных и смешанных показателей, но опыта в данной области до тех пор пока слишком мало. Главным требованием к выстроенной матрице есть ее хорошая полуопределенность. Эрмитова матрица именуется положительно полуопределенной, в случае, если все ее главные миноры неотрицательны. Из данного свойства именно и направляться неотрицательность всех собственных значений.

Способами факторного анализа решаются три главных вида задач:

- отыскание скрытых, но предполагаемых закономерностей, каковые определяются действием внутренних либо внешних обстоятельств на изучаемый процесс;

- изучение и выявление статистической связи показателей с факторами либо главными компонентами;

- сжатие информации методом описания процесса при помощи неспециализированных факторов либо основных компонент, число которых меньше количества первоначально забранных показателей (параметров), но с той либо другой степенью точности снабжающих воспроизведение корреляционной матрицы.

направляться пояснить, что в факторном анализе понимается под сжатием информации. Дело в том, что корреляционная матрица получается методом обработки исходного массива данных. Предполагался, что та же самая корреляционная матрица возможно взята с применением тех же объектов, но обрисованных меньшим числом параметров. Так, якобы происходит уменьшение размерности задачи, не смотря на то, что в действительности это не верно. Это не сжатие информации и в общепринятом смысле – вернуть данные по корреляционной матрице запрещено.

Коэффициенты корреляции, составляющие корреляционную матрицу, по умолчанию вычисляются между параметрами (показателями, тестами), а не между объектами (личностями, лицами), исходя из этого размерность корреляционной матрицы равна числу параметров. Это так называемая техника R. Но возможно, к примеру, изучена корреляция между объектами (правильнее, их состояниями, обрисовываемыми векторами параметров). Эта методика именуется техникой Q. Проведение факторного анализа техникой Q обосновано тем, что состояния объектов смогут иметь неспециализированную побудительную обстоятельство (обстоятельства), которая (каковые) именно и возможно распознана посредством факторного анализа. Существует кроме этого техника Р, предполагающая анализ изучений, выполненных на одном и том же индивидууме в разные промежутки времени («объекты» – одинаковый индивидуум в разные промежутки времени), причем изучаются корреляции между состояниями индивидуума. Аналог техники Q для последнего случая образовывает предмет изучения техники O.

В базе всех способов факторного анализа лежит предположение, что изучаемая зависимость носит линейный темперамент. Главное требование к исходным данным – это то, что они должны подчиняться многомерному обычному распределению. По крайней мере, должно быть сделано допущение о многомерном обычном распределении совокупности.

Редуцированием корреляционной матрицы именуется процесс замены единиц на основной диагонали корреляционной матрицы некоторыми размерами, именуемыми общностями. Общность – сумма квадратов факторных нагрузок. Общность данной переменной – та часть ее дисперсии, которая обусловлена неспециализированными факторами. Это вытекает из предположения что полная дисперсия складывается из неспециализированной дисперсии, обусловленной неспециализированными для всех переменных факторами, и специфичной дисперсии, обусловленной факторами, специфичными лишь для данной переменной, и дисперсии, обусловленной неточностью.

Получение матрицы факторного отображения в принципе есть целью факторного анализа. Ее строчки представляют собой координаты финишей векторов, соответствующих т переменным в r-мерном факторном пространстве. Близость финишей этих векторов дает представление о обоюдной зависимости переменных. Любой вектор в сжатой, концентрированной форме несет данные о ходе. Близость этих векторов дает представление о обоюдной зависимости переменных. Дополнительно, в случае, если число выделенных факторов больше единицы, в большинстве случаев производится вращение матрицы факторного отображения с целью получения так называемой несложной структуры.

Для наглядности результаты возможно изобразить графически, что, но, проблематично для трех и более выделенных факторов. Исходя из этого в большинстве случаев дают изображение r -мерного факторного пространства в двумерных срезах.

В ходе ответа задачи факторного анализа необходимо готовься к тому, что время от времени ответ взять не удается. Это позвано сложностью решаемой неприятности собственных значений корреляционной матрицы. К примеру, корреляционная матрица может оказаться вырожденной, что возможно позвано совпадением либо полной линейной корреляцией параметров. Для матриц высоко порядка может случиться утрата значимости в ходе вычислений. Исходя из этого теоретически нельзя исключить обстановку, в то время, когда способы факторного анализа, к сожалению, окажутся неприменимы, по крайней мере , пока данные не удастся «исправить». Исправлены эти смогут быть следующим образом. Выявите линейно зависимые параметры посредством, к примеру, корреляционных плеяд и метода (допустимо использование и других способов) и покиньте в данных лишь один из группы линейно зависимых параметров.

СПОСОБ Основных КОМПОНЕНТ

С повышением размерности признакового пространства возрастают трудности изучения геологических объектов, и появляется неприятность замены бессчётных замечаемых показателей меньшим их числом, без значительной утраты нужной информации. Одним из самый распространенных способов ответа данной задачи есть способ основных компонент.

Базой способа основных компонент есть линейное преобразование т исходных переменных (показателей) в т новых переменных, где любая новая переменная представляет собой линейное сочетание исходных. В ходе преобразования векторы замечаемых переменных заменяются новыми векторами (главными компонентами), каковые вносят быстро разные вклады в суммарную дисперсию многомерных показателей. Сокращение пространства показателей достигается методом отбора нескольких самые информативных компонент, снабжающих главную долю суммарной дисперсии, что ведет к заметному уменьшению их общего количества за счет наименее информативных компонент, отражающих малые доли суммарной дисперсии.

Главные компоненты – это личные векторы ковариационных матриц исходных показателей. Число собственных векторов ковариационной матрицы определяется числом изучаемых показателей, другими словами равно ее столбцов (либо строчков). Любой личный вектор (основная компонента) характеризуется координатами и собственным значением.

Личные значения ковариационной матрицы (?j) – это длины ее собственных векторов, другими словами их дисперсии. Суммы собственных значений ковариационной матрицы равны ее следу, другими словами сумме ее диагональных элементов.

Координаты собственного вектора ковариационной матрицы (?ij) – это числовые коэффициенты, характеризующие его положение в т мерном признаковом пространстве. Число точечных координат каждого собственного вектора (?ij) – ?1, ?2, …, ?m определяется размерностью пространства, а их численные значения – это коэффициенты линейных уравнений данного собственного вектора.

Личные значения ковариационной матрицы находятся как характеристические корни полиномиальных уравнений методом их решения. Но осуществить это для громадных значений т весьма сложно. Исходя из этого в вычислительной практике их определяют способами матричных преобразований (методом последовательных приближений к собственным значениям), каковые смогут быть реализованы лишь посредством ЭВМ. Способы отыскания координат собственных векторов симметричных матриц кроме этого сложны и требуют применения ЭВМ.

Потому, что ковариационные матрицы исходных показателей симметричны, их личные векторы в любой момент ортогональны, а составляющие их переменные взаимонезависимы, другими словами не коррелированы между собой.

В способе основных компонент координаты собственных векторов рассматриваются как нагрузки соответствующих переменных на тот либо другой фактор. Они употребляются для расчета матриц нового (множества совокупностей методом проектирования векторов данных (показателей х1, х2, …, хm) на оси собственных векторов (?1, ?2, …, ?m):

, (VII.1)

, (VII.1)

где – нагрузки j-й компоненты в i-й переменной показателя. Посредством формулы (VII.1) исходная матрица наблюденных показателей размерности п x т пересчитывается в матрицу новых переменных (той же размерности), учитывающих личные значения каждой из компонент. В случае, если статистические (корреляционные) связи между наблюденными показателями многомерного пространства проявляются достаточно четко, то разложение исходной матрицы наблюдений на т новых компонент ведет к заметному возрастанию контрастности распределения дисперсий по новым компонентам, в сравнении с исходными векторами. В большинстве случаев, дисперсия одной из основных компонент достигает половины и более от суммарной дисперсии показателей, а в совокупности с дисперсиями еще одной-двух последующих компонент, их неспециализированный вклад в суммарную дисперсию превышает 90%.

Так, без значительной утраты информации об изменчивости наблюденных показателей возможно заметно сократить размерность пространства наблюденных показателей (до p?m), ограничившись данными по двум-трем самые информативным главным компонентам. Это разрешает вычислять, что вместо исходной матрицы размерностью п x m, для целей геологического анализа может употребляться матрица основных компонент размерностью п x p (где p, в большинстве случаев не превышает 2 – 3). Потому, что новые переменные в данной матрице представлены некоррелированными размерами, способ основных компонент может рассматриваться как замечательное средство определения подлинного числа линейно свободных векторов, содержащихся в исходной матрице.

Нормальное распределение в Excel

Интересные записи:

- Приложения (предполагаемые, т.к. студент может на свое усмотрение добавить что-то)

- Приложение i. значения функции нормального распределения с параметрами 0 и 1 (для отрицательных значений z) 7 глава

- Применение гаси при тушении пожаров

- Приложение i. значения функции нормального распределения с параметрами 0 и 1 (для отрицательных значений z) 5 глава